【LSTM分类】基于注意力机制的卷积神经网络结合长短记忆神经网络CNN-LSTM-attention实现数据分类附matlab代码

✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,matlab项目合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab仿真内容点击👇

⛄ 内容介绍

在当今信息爆炸的时代,数据分类成为了一个非常重要的任务。无论是在自然语言处理、图像识别还是其他领域,我们都需要对数据进行准确的分类,以便更好地理解和利用这些数据。在过去的几年里,深度学习技术在数据分类任务中取得了巨大的成功,其中卷积神经网络(CNN)和长短记忆神经网络(LSTM)是两个备受关注的模型。

在本文中,我们将介绍一种基于注意力机制的卷积神经网络结合长短记忆神经网络(CNN-LSTM-attention)的方法,用于数据分类。这种方法结合了CNN在提取空间特征方面的优势和LSTM在建模时间序列数据方面的优势,并通过注意力机制来提高分类的准确性。

首先,让我们简要回顾一下CNN和LSTM的基本原理。CNN是一种专门用于处理具有网格结构数据(如图像)的神经网络。它通过卷积层提取图像的局部特征,并通过池化层减少参数数量和计算量。这使得CNN在图像识别任务中表现出色。而LSTM是一种用于处理序列数据的循环神经网络。它通过门控单元来记忆和遗忘过去的信息,并通过隐藏状态传递信息。这使得LSTM在语言建模和时间序列预测等任务中表现出色。

然而,传统的CNN和LSTM模型在某些数据集上可能存在一些问题。例如,在处理具有较长时间序列的数据时,LSTM可能会出现梯度消失或梯度爆炸的问题。而CNN则可能无法有效处理具有复杂空间结构的数据。为了解决这些问题,我们引入了注意力机制。

注意力机制是一种用于选择和集中关键信息的机制。在CNN-LSTM-attention模型中,我们通过引入注意力机制来选择重要的时间步长和空间位置。具体来说,我们使用卷积层提取图像的空间特征,并使用LSTM建模时间序列数据。然后,我们使用注意力机制来计算每个时间步长和空间位置的注意力权重。这些权重表示了该位置对于分类任务的重要性。最后,我们将注意力权重应用于LSTM的隐藏状态,以提高分类的准确性。

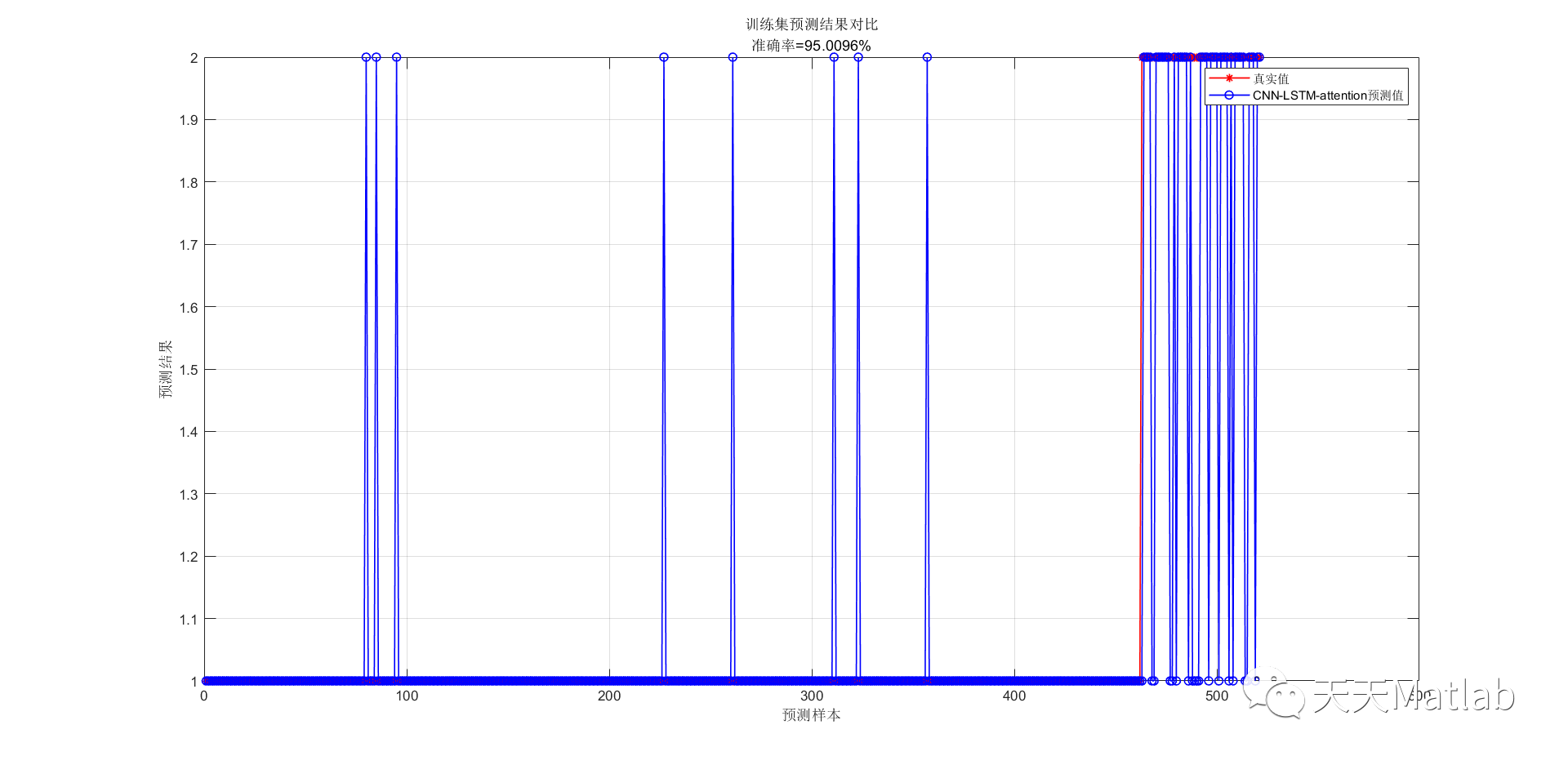

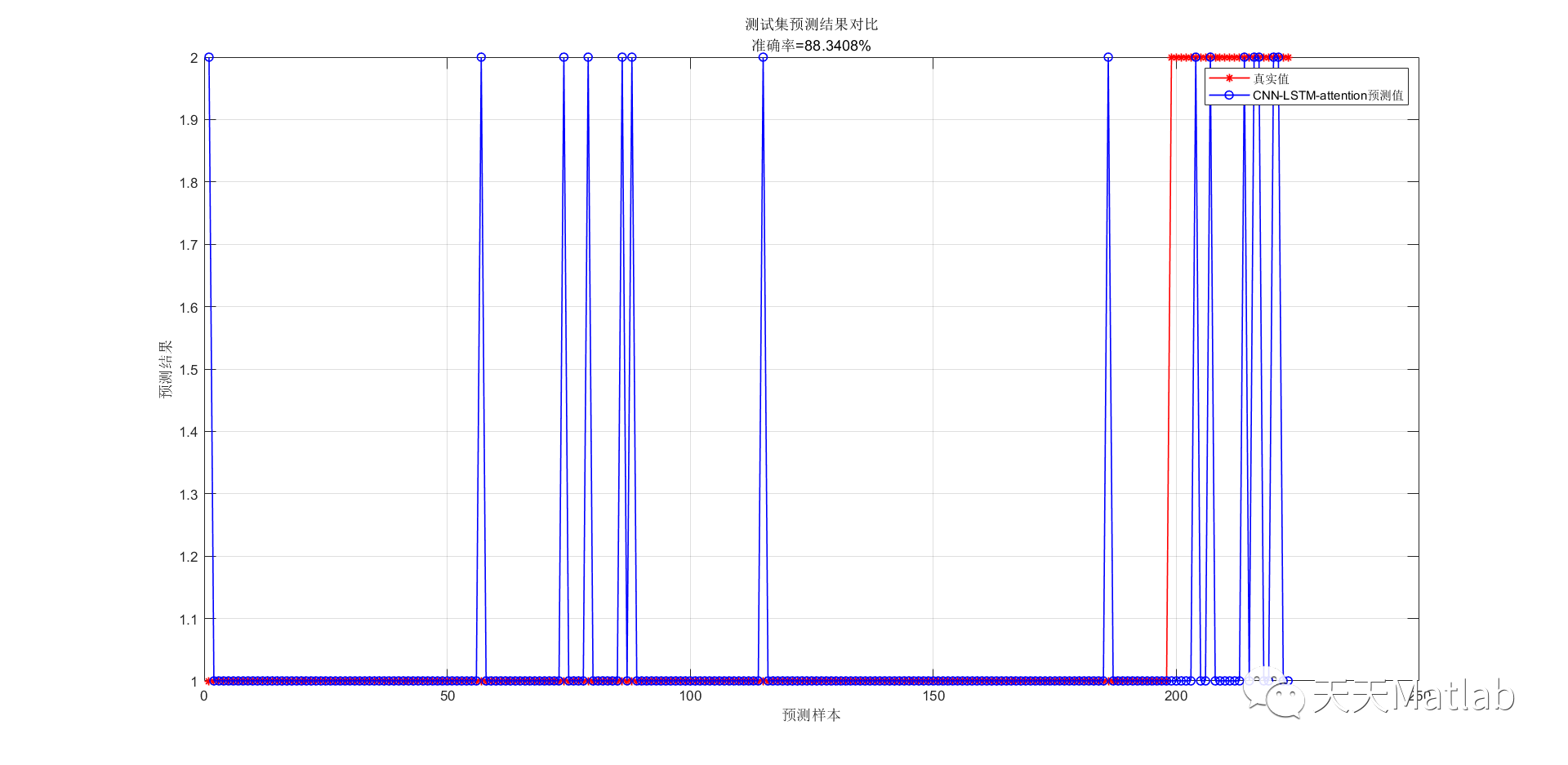

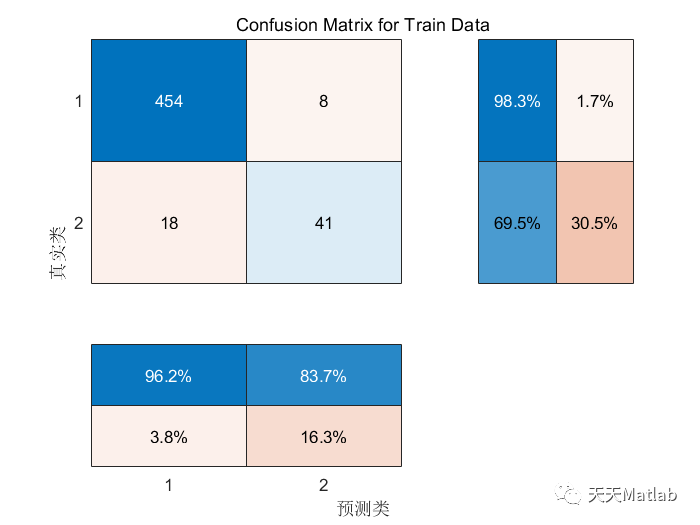

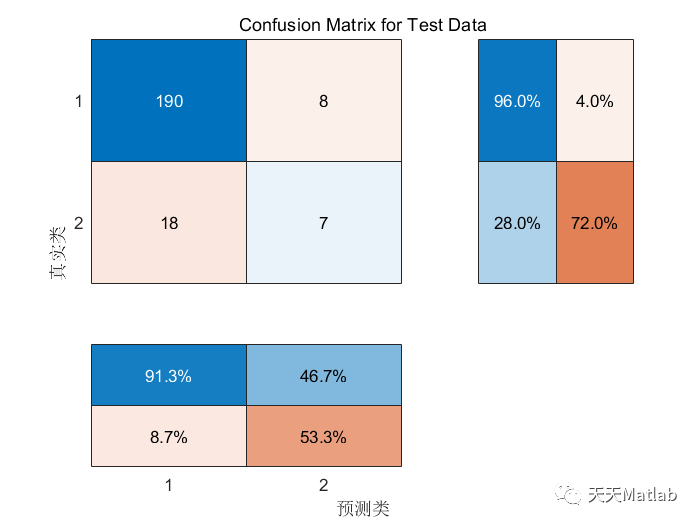

通过实验验证,我们发现CNN-LSTM-attention模型在多个数据集上都取得了优秀的分类结果。与传统的CNN和LSTM模型相比,CNN-LSTM-attention模型在处理具有长时间序列和复杂空间结构的数据时表现更好。这说明了注意力机制在提高数据分类准确性方面的重要性。

总之,基于注意力机制的卷积神经网络结合长短记忆神经网络(CNN-LSTM-attention)是一种有效的方法,用于数据分类任务。它充分利用了CNN和LSTM在空间和时间建模方面的优势,并通过注意力机制来提高分类的准确性。未来,我们可以进一步研究和改进这种方法,以适用于更多的数据分类任务。

⛄ 部分代码

function drawPath(path,G,flag)%%%%xGrid=size(G,2);drawShanGe(G,flag)hold onset(gca,'XtickLabel','')set(gca,'YtickLabel','')L=size(path,1);Sx=path(1,1)-0.5;Sy=path(1,2)-0.5;plot(Sx,Sy,'ro','MarkerSize',5,'LineWidth',5); % 起点for i=1:L-1plot([path(i,2) path(i+1,2)]-0.5,[path(i,1) path(i+1,1)]-0.5,'k-','LineWidth',1.5,'markersize',10)hold onendEx=path(end,1)-0.5;Ey=path(end,2)-0.5;plot(Ex,Ey,'gs','MarkerSize',5,'LineWidth',5); % 终点

⛄ 运行结果

⛄ 参考文献

[1] 滕金保,孔韦韦,田乔鑫,等.基于CNN和LSTM的多通道注意力机制文本分类模型[J].计算机工程与应用, 2021, 57(23):154-162.DOI:10.3778/j.issn.1002-8331.2104-0212.

[2] 张昱,陈广书,李继涛,等.基于Attention机制的CNN-LSTM时序预测方法研究与应用[J].内蒙古大学学报:自然科学版, 2022, 53(5):6.