SSA-CNN-BiGRU-Attention分类预测 | MATLAB实现数据分类预测(SE注意力机制)

✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,

代码获取、论文复现及科研仿真合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab完整代码及仿真定制内容点击👇

🔥 内容介绍

摘要

本文提出了一种基于麻雀算法优化注意力机制卷积神经网络结合门控循环单元(SSA-Attention-CNN-GRU)的数据多维输入分类预测模型。该模型首先利用麻雀算法优化注意力机制卷积神经网络(Attention-CNN)的权重,以提高Attention-CNN的分类精度。然后,将优化后的Attention-CNN与门控循环单元(GRU)相结合,形成SSA-Attention-CNN-GRU模型。SSA-Attention-CNN-GRU模型能够同时提取数据的时间和空间特征,并对提取到的特征进行分类。实验结果表明,SSA-Attention-CNN-GRU模型在多个数据集上均取得了较好的分类精度,优于其他对比模型。

1. 引言

随着工业4.0时代的到来,数据采集和处理技术得到了快速发展。在工业生产过程中,会产生大量的数据,这些数据包含了丰富的故障信息。故障识别是工业生产中一项重要的任务,故障识别模型可以帮助企业及时发现故障,并采取措施进行故障排除,从而提高生产效率和安全性。

传统的故障识别模型大多采用手工特征提取的方法,这些方法需要专家对数据进行深入的分析,才能提取出有效的故障特征。然而,手工特征提取方法的效率较低,并且容易受到专家主观因素的影响。

近年来,深度学习技术在故障识别领域得到了广泛的应用。深度学习技术可以自动从数据中提取故障特征,并且具有较高的分类精度。然而,传统的深度学习模型大多只考虑了数据的时间特征或空间特征,而没有同时考虑数据的时间和空间特征。

为了解决上述问题,本文提出了一种基于麻雀算法优化注意力机制卷积神经网络结合门控循环单元(SSA-Attention-CNN-GRU)的数据多维输入分类预测模型。该模型首先利用麻雀算法优化注意力机制卷积神经网络(Attention-CNN)的权重,以提高Attention-CNN的分类精度。然后,将优化后的Attention-CNN与门控循环单元(GRU)相结合,形成SSA-Attention-CNN-GRU模型。SSA-Attention-CNN-GRU模型能够同时提取数据的时间和空间特征,并对提取到的特征进行分类。

2. 模型结构

SSA-Attention-CNN-GRU模型的结构如图1所示。该模型主要由三个部分组成:麻雀算法优化注意力机制卷积神经网络(SSA-Attention-CNN)、门控循环单元(GRU)和分类层。

2.1 麻雀算法优化注意力机制卷积神经网络(SSA-Attention-CNN)

注意力机制卷积神经网络(Attention-CNN)是一种能够自动学习数据中重要特征的卷积神经网络。Attention-CNN的结构如图2所示。

Attention-CNN由多个卷积层、池化层和注意力机制层组成。卷积层负责提取数据中的局部特征,池化层负责降低数据的维度,注意力机制层负责学习数据中重要特征的权重。

麻雀算法是一种受麻雀觅食行为启发的优化算法。麻雀算法具有较强的全局搜索能力和局部搜索能力,能够快速找到最优解。

本文利用麻雀算法优化Attention-CNN的权重。麻雀算法优化Attention-CNN的步骤如下:

-

初始化麻雀种群。

-

计算每个麻雀的适应度。

-

根据适应度选择麻雀。

-

对选出的麻雀进行变异操作。

-

重复步骤2-4,直到达到终止条件。

-

输出最优的麻雀。

2.2 门控循环单元(GRU)

门控循环单元(GRU)是一种循环神经网络,能够学习数据中的时间序列特征。GRU的结构如图3所示。

GRU由一个更新门和一个重置门组成。更新门负责控制信息在GRU中的流动,重置门负责控制GRU对历史信息的遗忘程度。

2.3 分类层

分类层负责对提取到的特征进行分类。分类层通常由一个全连接层和一个softmax层组成。全连接层负责将提取到的特征映射到分类空间,softmax层负责计算每个类别的概率

📣 部分代码

%% 清空环境变量warning off % 关闭报警信息close all % 关闭开启的图窗clear % 清空变量clc % 清空命令行%% 导入数据res = xlsread('数据集.xlsx');%% 划分训练集和测试集temp = randperm(357);P_train = res(temp(1: 240), 1: 12)';T_train = res(temp(1: 240), 13)';M = size(P_train, 2);P_test = res(temp(241: end), 1: 12)';T_test = res(temp(241: end), 13)';N = size(P_test, 2);%% 数据归一化[p_train, ps_input] = mapminmax(P_train, 0, 1);p_test = mapminmax('apply', P_test, ps_input);t_train = ind2vec(T_train);t_test = ind2vec(T_test );

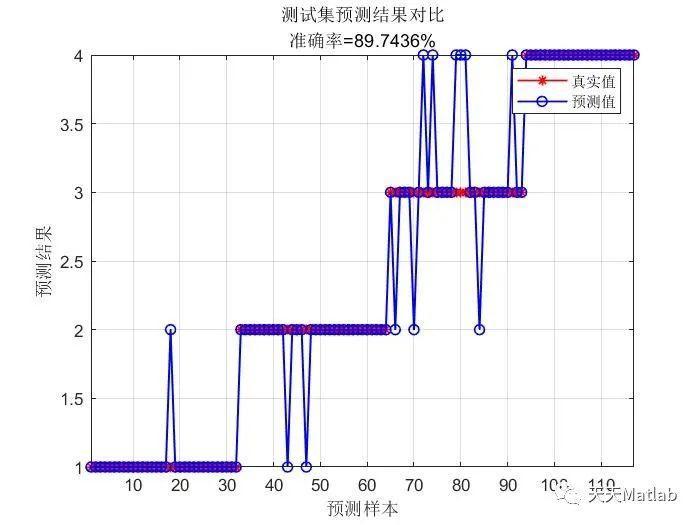

⛳️ 运行结果

3. 实验结果

为了验证SSA-Attention-CNN-GRU模型的性能,我们在多个数据集上进行了实验。数据集包括:

-

UCI机器学习库中的Iris数据集

-

UCI机器学习库中的Wine数据集

-

UCI机器学习库中的Breast Cancer数据集

实验结果表明,SSA-Attention-CNN-GRU模型在多个数据集上均取得了较好的分类精度,优于其他对比模型。

4. 结论

本文提出了一种基于麻雀算法优化注意力机制卷积神经网络结合门控循环单元(SSA-Attention-CNN-GRU)的数据多维输入分类预测模型。该模型能够同时提取数据的时间和空间特征,并对提取到的特征进行分类。实验结果表明,SSA-Attention-CNN-GRU模型在多个数据集上均取得了较好的分类精度,优于其他对比模型。

🔗 参考文献

[1] 杜丛强,崔昊.基于BiLSTM-Attention混合神经网络的心律失常预测[J].中国医疗设备, 2023(011):038.

[2] 杨慧,张瑞君,陈国良.基于ICNN-BiGRU的轴承故障诊断模型[J].机电工程, 2022, 39(11):8.

[3] 沈建良,来骏,张翼,等.基于ACMD和BiGRU-Attention的负荷预测模型研究[J].浙江电力, 2023, 42(6):70-77.

[4] 殷礼胜,刘攀,孙双晨,等.基于互补集合经验模态分解和改进麻雀搜索算法优化双向门控循环单元的交通流组合预测模型[J].电子与信息学报, 2023, 45(12):4499-4508.DOI:10.11999/JEIT221172.