深度学习今年来经典模型优缺点总结,包括卷积、循环卷积、Transformer、LSTM、GANs等

文章目录

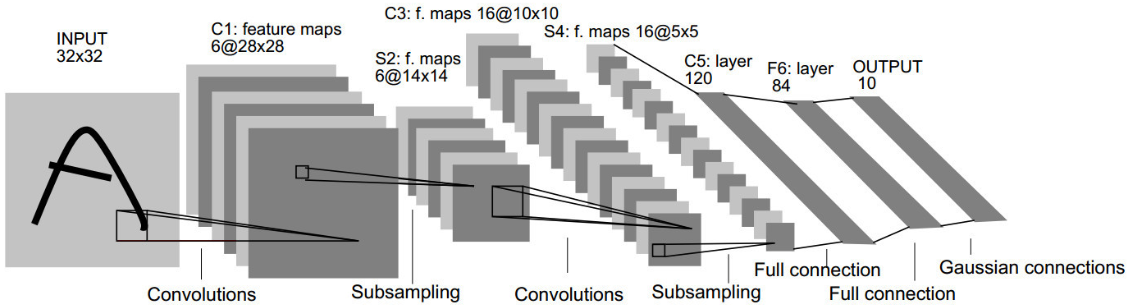

1、卷积神经网络(Convolutional Neural Networks,CNN)

1.1 优点

- 可用于图像处理和计算机视觉领域任务,包括图像分类、人物检索、物体重识别、物体检测和图像分割。

- 通过卷积层有效捕捉图像中的局部特征(这是跟 transformer 的区别,transformer 关注全局信息)。

- 具有平移不变性。

1.2 缺点

- 需要大规模的标记图像数据进行训练。

- 在其他领域的任务上性能可能不如前馈神经网络。

1.3 应用场景

适用场景:图像分类、目标检测等。

案例:图像识别。将图像分类为不同的物体或场景。

1.4 网络图

《Gradient-based learning applied to document recognition》;LeNet-5

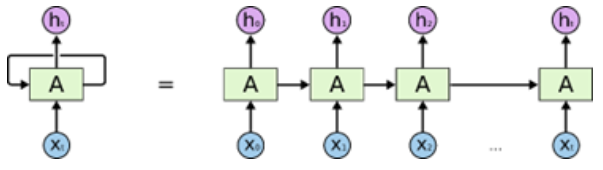

2、循环神经网络(Recurrent Neural Networks,RNNs)

2.1 优点

- 适用于序列数据,如自然语言处理和时间序列分析。

- 具有循环连接,可以处理不定长的序列数据。

- 具有记忆能力,可以捕捉时间依赖性。

2.2 缺点

- 梯度消失问题,导致长序列的性能下降。

- 计算复杂性较高,不适用于大规模数据和深度网络。

2.3 应用场景

适用场景:序列建模、自然语言处理等。

案例:语音识别。将口头语言转换为文本。

2.4 网络图

《Recurrent Neural Networks》

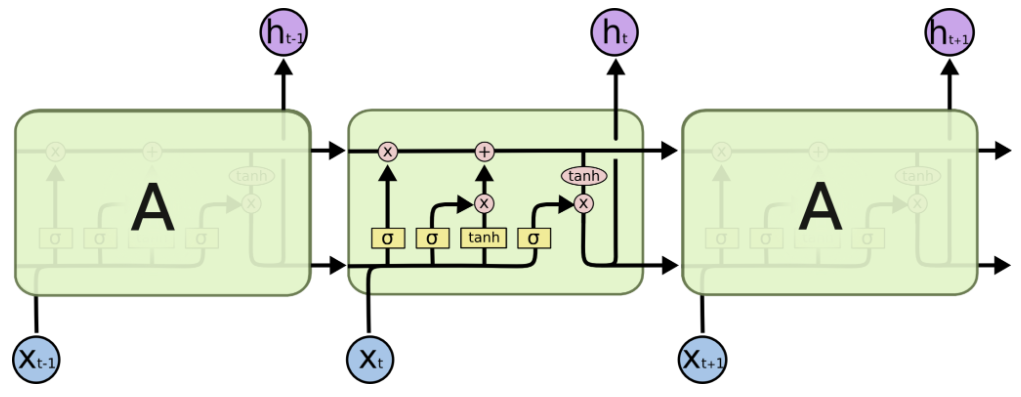

3、长短时记忆网络(Long Short-Term Memory,LSTM)

3.1 优点

- 解决了RNN的梯度消失问题。

- 适用于长序列的建模。

- 在自然语言处理等领域取得了显著的成功。

3.2 缺点

- 计算复杂性较高。

- 需要大量的数据来训练深层 LSTM 网络。

3.3 应用场景

适用场景:处理长序列和时间序列数据。

案例:股票价格预测。预测金融市场的趋势。

3.4 网络图

《Long Short-Term Memory networks》

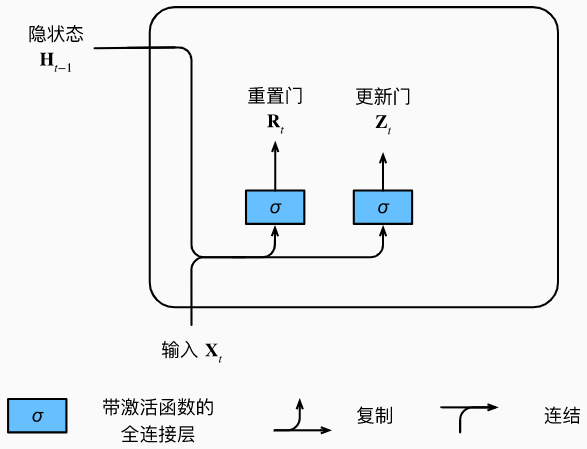

4、门控循环单元(Gated Recurrent Unit,GRU)

4.1 优点

- 类似于 LSTM,但参数较少,计算复杂性较低。

- 在某些任务上性能与 LSTM 相媲美。

4.2 缺点

- 对于某些复杂任务,性能可能不如LSTM。

4.3 应用场景

适用场景:用于序列数据处理,与 LSTM 类似。

案例:情感分析。分析文本中的情感。

4.4 网络图

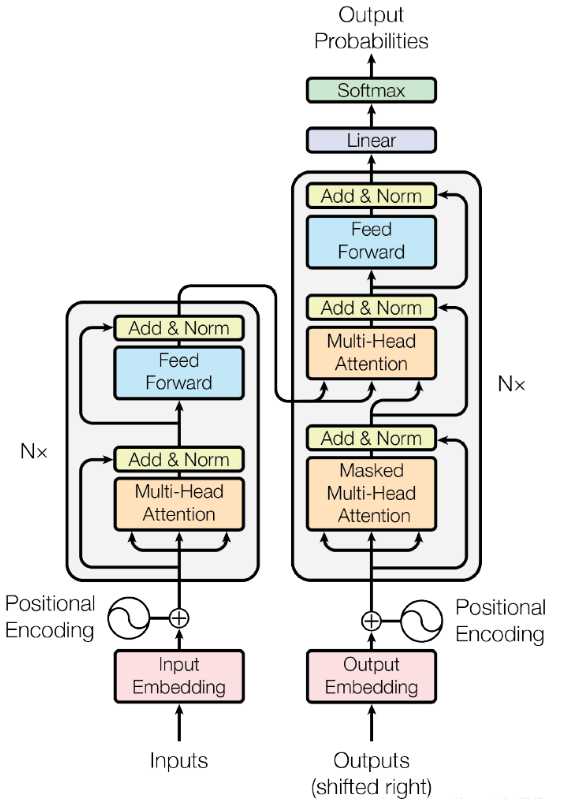

5、自注意力模型(Transformer)

5.1 优点

- 适用于自然语言处理和序列建模等任务。

- 可并行化,计算效率高。

- 在大规模数据和深度模型上表现出色。

5.2 缺点

- 需要大规模的数据来训练。

- 相对较新的模型,可能不适用于所有任务。

5.3 应用场景

适用场景:用于自然语言处理、机器翻译等。

案例:机器翻译。将一种语言的文本翻译为另一种语言。

5.4 网络图

《Attention is All you need》

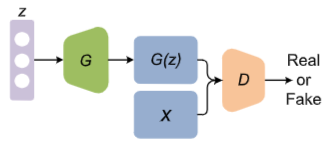

6、生成对抗网络(Generative Adversarial Networks,GANs)

6.1 优点

- 用于生成数据和图像,以及进行无监督学习。

- 生成高质量的样本。

- 在图像生成、风格迁移等领域取得了显著的成功。

6.2 缺点

- 训练复杂性高,稳定性差,需要谨慎调整超参数。

- 对于某些任务,可能存在模式崩溃问题。

- 相较于最新的扩散模型,生成的质量和效果不具有竞争性,特定的生成数据可能存在一定的噪声。

6.3 应用场景

适用场景:用于生成图像、音频、文本等。

案例:图像生成。生成逼真的图像。

6.4 网络图

《Generative Adversarial Nets》

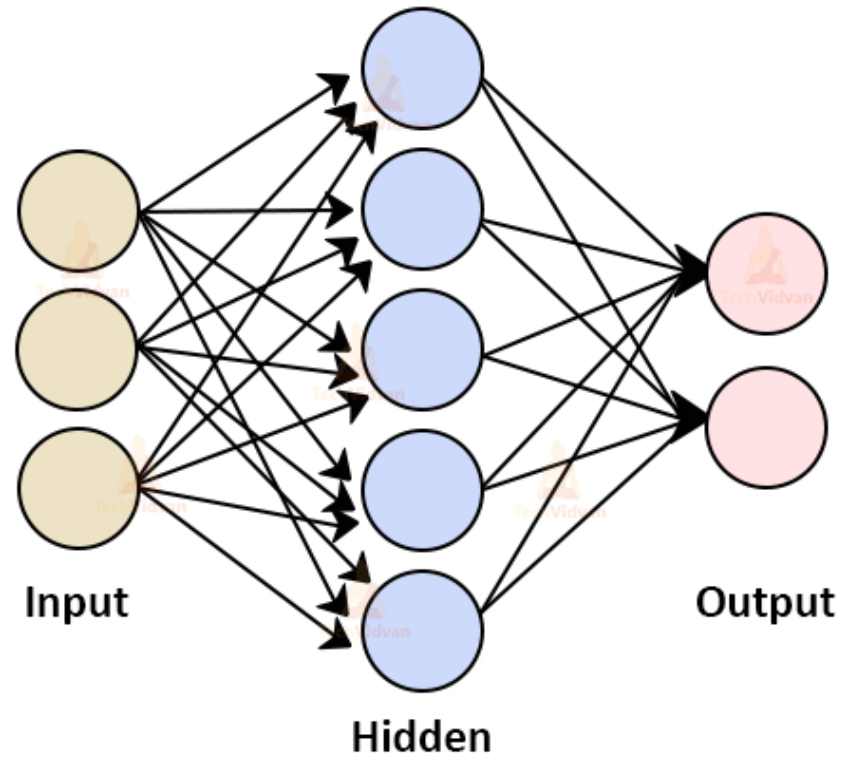

7、人工神经网络

最后,再介绍一种人工神经网络:前馈神经网络(Feedforward Neural Networks,FNNs)。

7.1 优点

- 适用于各种任务,包括分类和回归。

- 具有很强的表示能力,可以捕捉复杂的非线性关系。

- 针对深度学习问题提供了基础。

7.2 缺点

- 对于小样本数据,容易出现过拟合。

- 需要大量的标记数据进行训练。

7.3 应用场景

适用场景:用于分类和回归任务。

案例:图像分类。将图像分为不同的类别。

7.4 网络图