Diverse Embedding Expansion Network and Low-Light Cross-Modality Benchmark for V-I Re-ID:如何有效利用生成嵌入?

文章目录

题目:Diverse Embedding Expansion Network and Low-Light Cross-Modality Benchmark for Visible-Infrared Person Re-identification (多种嵌入扩展网络和低光交叉模态的可见-红外行人重识别)

期刊合集:最近五年,包含顶刊,顶会,学报>>网址

文章来源:CVPR 2023

官方代码:GitHub

研究背景

VIS 和 IR 图像之间存在额外的跨模态差异是跨模态行人重识别的巨大挑战。作者系统分析了以往研究,并总结相关的研究方法:第一,特征级方法,思路: 将 VIS 和 IR 特征投影到一个共同的嵌入空间中,最小化模态差异。出现的问题: 由于模态差异较大,难以将跨模态图像直接投影到公共特征空间中。第二,图像级方法,思路: 通过使用Gans网络生成相反图像来减少模态差异。出现的问题: 缺乏 VIS-IR 图像对,生成的跨模态图像通常伴随着一些噪声。

论文分析

网络框架

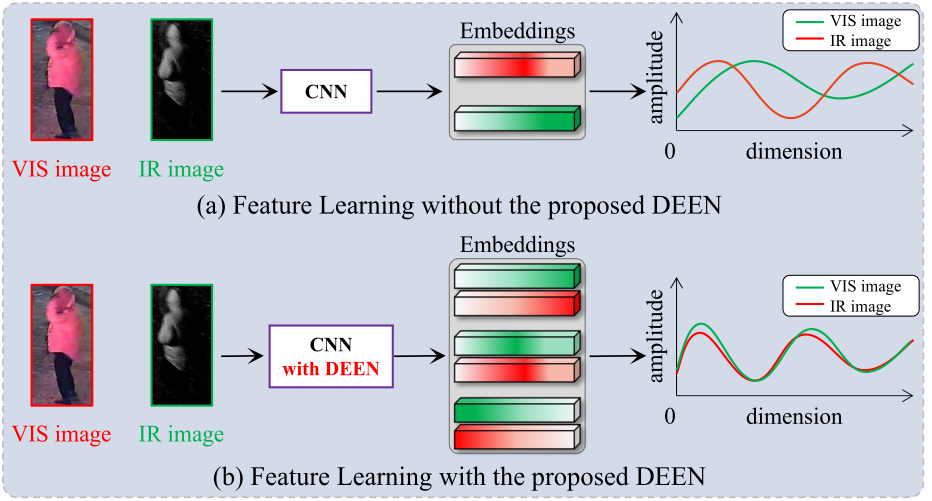

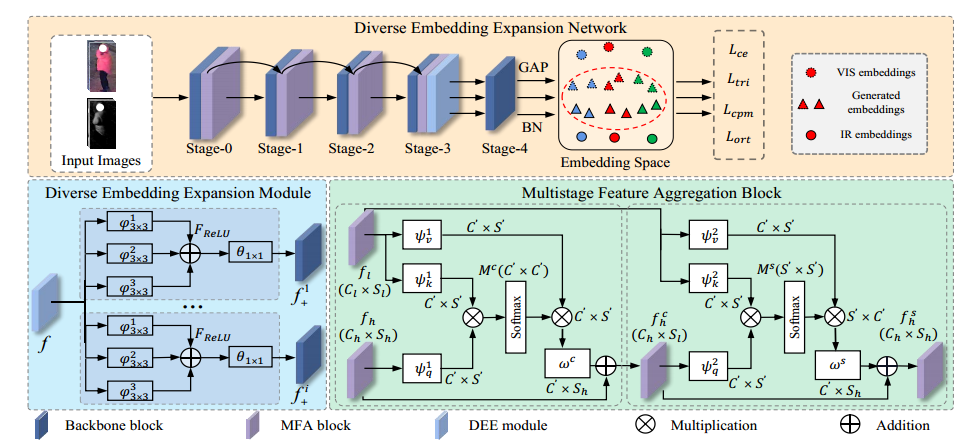

多样性嵌入的网络模型(DEMN),使用双流的 ResNet-50 网络,将 VIS-IR 特征输入到所提出的多元嵌入扩展(DEE)模块中,以生成更多嵌入,之后,使用了中心引导对挖掘(CPM)损失,使生成的嵌入尽可能多样化,以学习信息特征表示。

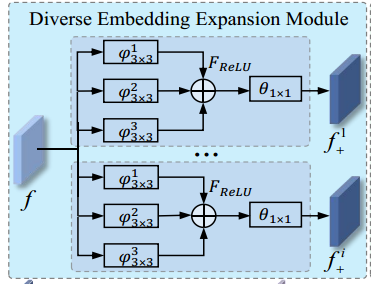

1、Diverse Embedding Expansion Module(多种嵌入扩展模块)

提出的DEE模块采用多分支卷积生成结构,生成更多的嵌入,以缓解训练数据不足的问题。

具体步骤:

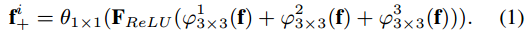

如上图所示,对于DEE的每个分支,使用三个3×3的扩展卷积层,它们具有不同的扩展比(从上往下依次是1,2,3),将特征映射的数量f减少到其自身大小的1/4,将得到的一个个小特征图组合成新的大特征图 F,再通过ReLU层来提高DEE的非线性表示能力。最后馈送到卷积层θ1×1(核大小为1×1),得到与 f 相同维度的嵌入特征,嵌入函数如下:

将所有生成的嵌入连接在一起,作为骨干网下一阶段的输入。

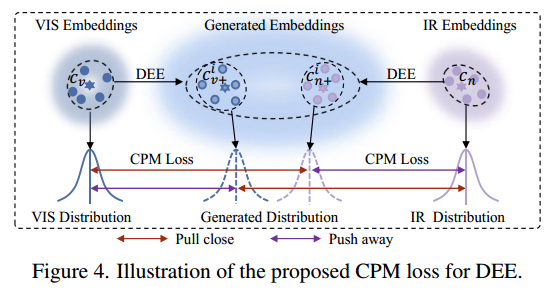

2、Center-Guided Pair Mining Loss(中心引导对挖掘损失)

作者认为,经过上面的操作,DEE模块只能使用多分支卷积块生成更多嵌入(只是有了更多的嵌入,但嵌入的内容或者是类型还没做要求),不能有效地获得多样化的嵌入。因此,需要利用以下三个属性来约束生成的嵌入尽可能多样化,以有效减少VIS和IR图像之间的模态差异: 一句话,既然都做了,那就得做好一点才行。

属性1:生成的嵌入应该尽可能多样化,以有效地学习信息特征表示。 推开同一模态生成的嵌入与原始嵌入之间的距离(模态都会成生成嵌入),以学习不同的特征并挖掘不同的跨模态线索。(同一模态学够了,再学也没用,已经提不高了,再找找其他模态的东西学习。)

属性2:生成的嵌入应该有助于减少VIS和IR图像之间的模态差异。 拉近由VIS模态生成的嵌入与原始IR嵌入之间的距离。同样的,拉近由IR模态生成的嵌入与原始VIS嵌入之间的距离。(你找我来,我找你,大家相互学,共同进步。)

属性3:类内距离应小于类间距离。 利用属性 2,会将生成的嵌入与原始嵌入之间的距离推近(不是我们所希望的),这可能导致不同类别的嵌入变得更近。因此,拉近距离的过程中,要保持类内距离小于类间距离。(把握好尺度关系,学了其他的东西,但是不能忘本,还是要精通自己的东西。)

这个过程就可以通过损失函数实现,结构和定义如下(图文并茂,很好理解):

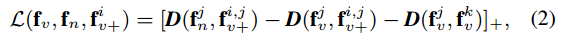

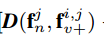

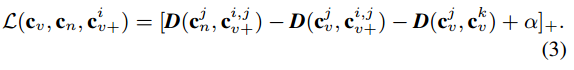

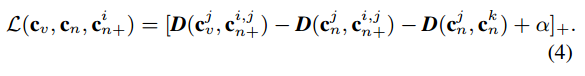

上述式子中的D(·,·)为两个嵌入之间的欧几里得距离,fv和fn是来自VIS和IR模态的原始嵌入,f i v+是来自 VIS 模态的第 i 个分支生成的嵌入。

3个属性分别在公式中有所体现, 这个就是为了将生成的嵌入(逗号后)拉向原始IR的嵌入(逗号前),以减小两者(括号里面的东西)之间的模态差异(属性1)。

这个就是为了将生成的嵌入(逗号后)拉向原始IR的嵌入(逗号前),以减小两者(括号里面的东西)之间的模态差异(属性1)。 将生成的嵌入(逗号后)推离VIS的嵌入(逗号前),使fv+能够学习信息特征表示(属性2)。

将生成的嵌入(逗号后)推离VIS的嵌入(逗号前),使fv+能够学习信息特征表示(属性2)。 使类内距离小于类间距离(属性3)。

使类内距离小于类间距离(属性3)。

每个类使用cn和cv表示中心点的表示,让对应生成的嵌入中心更有判别性,同时使用了一个边际项α来平衡前面的三项,改造如下所示:

相似的,对于由 IR 生成的嵌入的类中心损失:

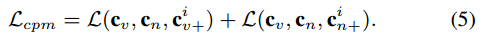

因此,最终 CPM 损失可表示为:

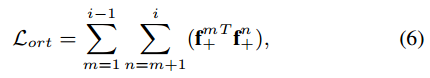

作者还做了一个工作:为了保证不同分支生成的嵌入能够捕获不同的信息特征表示,强制不同分支生成的不同嵌入正交,以最小化重叠元素(在生成嵌入后,做一次嵌入正交,以保证后续操作的有效性)。正交损耗表示为:

其中 m 和 n 分别是由原始嵌入生成的第 m 个和第 n 个嵌入。正交损失可以强制生成的嵌入学习更多信息的特征表示。

3、Multistage Feature Aggregation Block(多级特征聚合块)

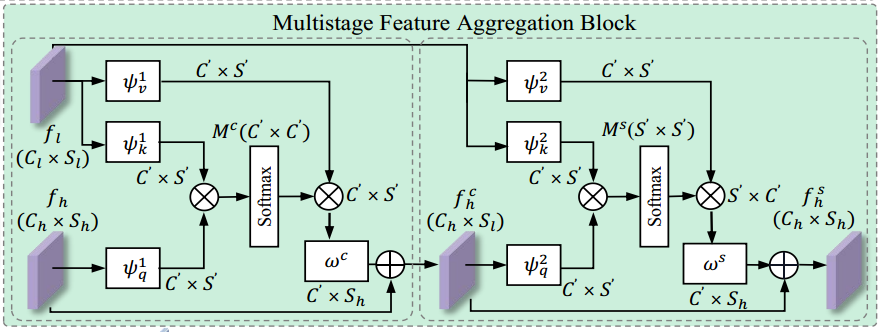

不同层次的特征聚合已被证明有助于语义分割、分类和检测任务。为了聚合来自不同阶段的特征以挖掘不同的通道和空间特征表示,结合了一个有效的通道-空间多阶段特征聚合(MFA)块来聚合多阶段特征。(这里主要考虑主干网各阶段通道空间聚合块的两类源特征:阶段前的低级特征图和阶段后的高级特征图,聚合就是自注意力机制的使用)

首先,使用三个1×1卷积层ψ 1q, ψ 1v, ψ 1k将 f 转换为三个紧凑嵌入:ψ 1q (fh), ψ 1v (fl)和ψ 1k (fl)。

1、通道聚合

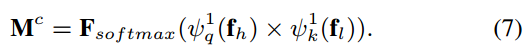

通道的相似度矩阵Mc∈R C ’ ×C '计算如下(c 代表了是channel,借鉴自注意力机制):

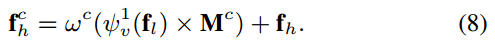

通过ψ1v (fl)和Mc的矩阵乘法来恢复通道维度,从而实现了通道的多级特征聚合。

2、空间聚合

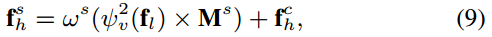

然后,利用上述运算得到的 f ch 和底层特征图 f l 进行空间特征聚合操作,类似于通道多阶段特征聚合操作。

其中 ω s和ψ 2 v是两个1 × 1卷积层,M s是空间相似矩阵。

4、Multi-Loss Optimization(多重损失优化)

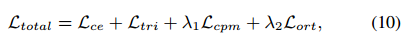

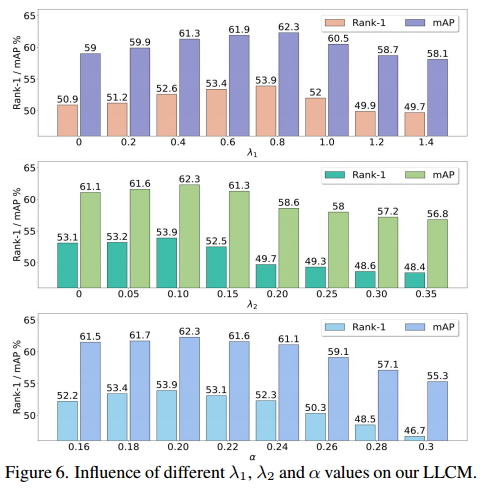

除了提出 L cpm和L ort外,文章还结合交叉熵损失L ce和三重熵损失L tri,通过最小化这四种损失L total的总和,以端到端方式共同优化网络,总损失如下:

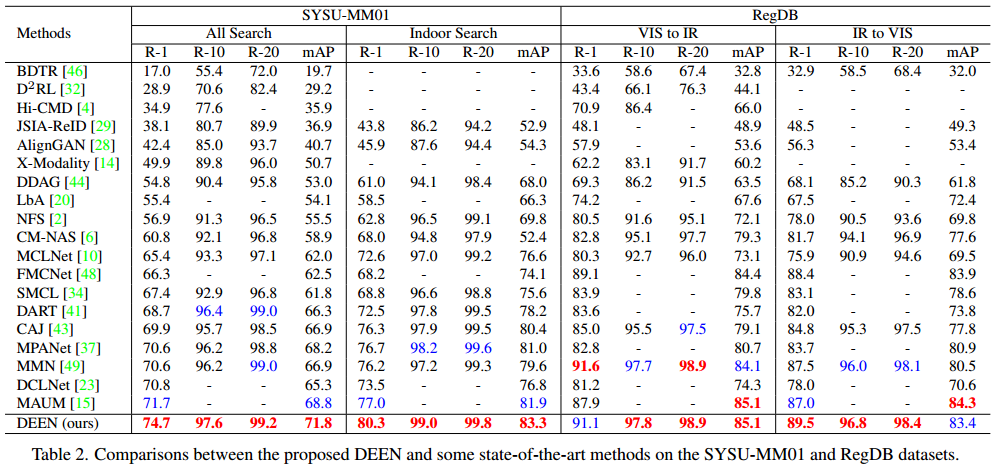

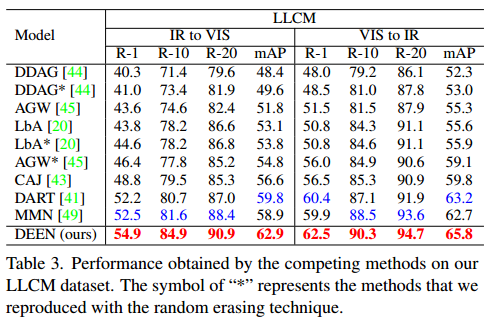

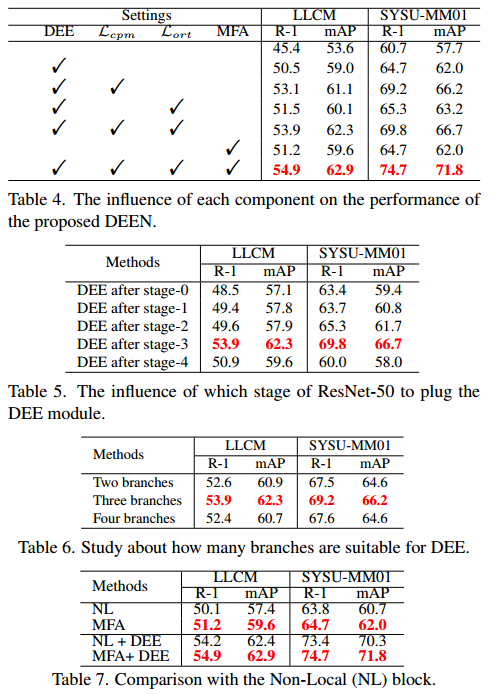

实验

实验细节:首先在训练阶段采用随机水平翻转和随机擦除操作,将所有输入图像的大小调整为3 × 384 × 144,初始学习率设置为1 × 10−2,通过预热策略(warm-up),10次后学习率增加到1 × 10−1。之后,在20 epoch将学习率衰减到1 × 10−2,在60 epoch和120 epoch分别进一步衰减到1 × 10−3和1 × 10−4,直到总共150 epoch。在每个小批中,随机选择6个身份的4张VIS图像和4张IR图像进行训练。训练采用SGD优化器,动量设置为0.9。特别地,对于RegDB数据集,删除了阶段4,并在阶段2之后将提出的DEE模块插入到DEEN中。

实验结果:

消融实验:总体的设置没做更改,只是删除了特定的模块。

超参数 λ1,λ2,α 设置。

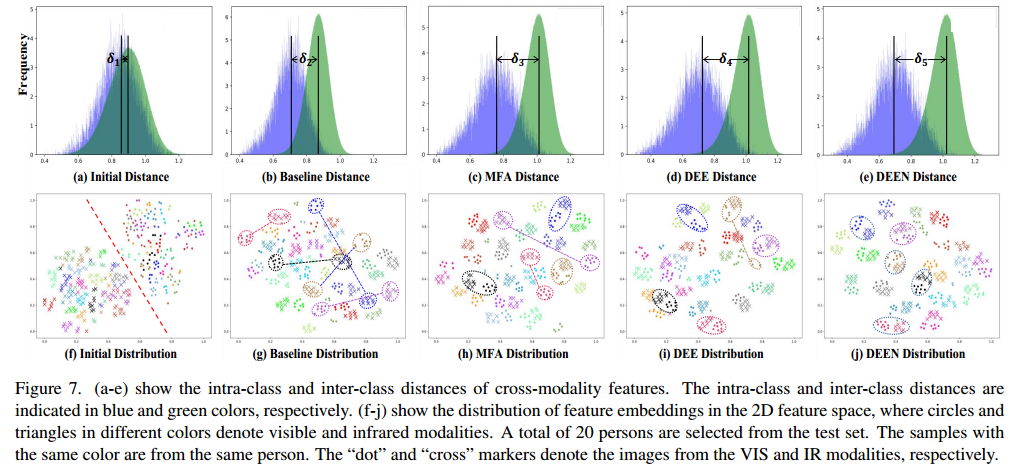

可视化: